검색결과 리스트

검색에 해당되는 글 3건

- 2009.01.06 검색엔진 최적화는 검색포탈의「악의 축」인가?

- 2009.01.06 구글 압도적 1위·네이버 5위…지구촌 '검색천하'

- 2009.01.05 네이버 일본검색 엔진, 정보 모으기는 성공할까

글

검색엔진 최적화는 검색포탈의「악의 축」인가?

구글 검색엔진은 품질가이드라인을 지키는 사이트를 원한다

지난 8월3일 구글 코리아는 공식 블로그를 통해서 “구글이 원하는 사이트는 무엇일까요?(http://googlekoreablog.blogspot.com/)”라는 주제로 구글 검색 가이드라인 및 검색엔진 최적화(SEO: Search Engine Optimization)에 대해서 소개했다.

구글 코리아 검색품질 팀 서은주씨 등 구글 담당자들이 작성한 “어떻게 하면 내 사이트가 구글에서 검색될 수 있을까?(http://googlekoreablog.blogspot.com/2007/08/blog-post.html)”라는 글을 통해서 “검색엔진 최적화 서비스나 기타 상위등록을 위한 작업이 반드시 사이트의 품질향상에 도움을 주는 것은 아니다”라며 “오히려 구글의 품질 가이드라인을 위배해 운영하는 사이트가 구글의 색인에서 제외되는 원인을 제공하기도 한다”고 설명하였다.

지난해 독일에서는 독일 BMW 사이트가 구글 검색결과 페이지에서 제외되는 일이 발생하였다. 소위 말하는 검색결과 퇴출 사건이다. 이유는 이 사이트가 검색엔진 최적화를 시도했기 때문이다.

작년 초부터 BMW사는 구글 검색결과 페이지 상위에 노출되기 위해서 ‘doorway page’라 불리는 기법을 이용하여 사용자 눈에는 보이지 않는 관련 키워드를 페이지 내에 잔뜩 심어놓고 서비스하였다. 이런 사실이 공개되고 BMW사는 즉각적으로 페이지를 교체하였고, 4일이 지난 뒤에 구글은 다시 BMW사를 다시 구글 검색에 복귀시키는 사건이 있었다.

공정한 검색결과 vs. 검색결과 검열

모든 검색엔진은 크건 작건 간에 자체적으로 검색엔진 최적화에 대한 페널티 정책을 가지고 있다. 구글의 BMW사에 대한 페널티 조치는 “검색엔진 최적화 기법은 검색결과를 조작하는 방법이고, 공정한 검색결과를 제공해야 하는 검색엔진의 정당화 논리에 정면으로 반박한다”라는 구글의 서비스 철학에 위배되기 때문이라고 주장하고 있다.

공정한 검색결과를 제공해야 한다는 명분은 분명히 일리가 있다. 하지만 많은 검색포탈들의 주 수익원인 검색광고는 공정한 검색결과라고 할 수 있는지 반박하고 싶다.

또한 검색엔진 최적화 방법이 저작권을 침해하는 것과 같은 범죄도 아니고, 비윤리적이라고 하기에도 애매한 부분이 있다. 얼마 전 중국에서는 검색결과 검열에 대한 구글의 행보에 대해서 더 이상 용납하지 않겠다는 주장도 일리가 있는 말이다.

그렇다면 많은 검색포탈들이 주장하는 ‘공정한 검색결과’라는 명분에 대해서 검색광고가 공정하다고 말할 수 있는지? 그리고 검색엔진 최적화가 검색결과의 순위를 조절하여 사용자를 기만하는 행위라고 볼 수 있는지 구체적으로 분석을 해 볼 필요가 있다.

검색포탈의 입장에서 얘기하자면 검색결과 최적화는 검색포탈들의 주 수익원인 검색광고에 피해를 주기 때문에 절대로 용납할 수 없는 ‘악’이라는 것이다. 직접 돈을 주는 검색광고는 사용자에 도움이 되는 정보이고, 돈을 내지 않는 검색엔진 최적화는 사용자에게 해가 되는 정보일까?

검색엔진 최적화 기법에는 어떤 것들이 있는가?

아이러니컬하게도 검색엔진 최적화 기법의 상당수의 방법들은 구글이 제공하는 ‘웹마스터 가이드라인(http://www.google.co.kr/support/webmasters/bin/answer.py?answer=35769)’에 소개되어 있다. 물론, 여기에 나오는 내용들은 구글 검색봇이 수집하기 좋게 페이지를 제작해야 한다는 내용과, 수집된 페이지가 분석하기 좋게 제작하는 방법들에 대해서 소개를 해주고 있다.

재미있는 건 여기에는 해서는 안 되는 행위에 대해서도 자세히 설명을 하고 있다. 사실 이 가이드라인대로만 페이지를 만들 때 또는 만들어진 페이지를 수정하게 되면 상당히 성과 있는 검색엔진 최적화가 된다. 문제는 여기서 하지 말아야 할 행위들에 대한 부분에 대해서 어떻게 해석할 것인가가 중요한 요소가 될 것이다.

검색엔진 최적화 기법에는 HTML의 ‘TITLE, ALT, META’ 태그들에 대해서 본문과 일치하는 그리고 충분히 페이지를 설명할 수 있는 키워드로 구성하는 것이 가장 기본이다. 그리고 동적인 URL을 사용하지 않기. 플래시, 자바스크립트, 리다이렉트를 사용하지 않기 등이 가장 일반화된 최적화 기법이다.

논란이 되는 부분은 독일 BMW사가 시도했던 숨겨진 텍스트나 링크를 사용하는 경우와 인위적인 링크 구성 등이다. 숨겨진 텍스트나 링크의 경우 사용자에게는 보여지지 않은 채 검색엔진이 분석할 때 혼란을 줄 수 있는 요소이기 때문에 문제의 소지가 있다.

하지만 인위적인 링크 구성의 경우 얘기가 달라진다. 웹 2.0 트랜드로 인하여 이제는 인위적인 링크를 만들기가 너무나 쉬워졌기 때문이다. RSS, 트랙백 등을 통해서 얼마든지 인위적인 링크 구성이 가능하고, 필요에 따라서는 인위적인 링크를 구성하기 위한 마이크로 사이트나 블로그 제작을 통해서도 가능하다.

검색엔진 최적화에 대한 다른 시각이 필요하다

그 동안 많은 사이트 제작자들은 화려한 사이트를 만드는 것에 급급하였고, 만들어진 사이트는 검색광고를 위해서 많은 돈을 지불하였다. 하지만 검색포탈들은 광고를 통해서 수익을 내는 데만 급급하였지 많은 인터넷 사이트들이 좀 더 검색결과에 잘 나올 수 있도록 페이지를 구성하는 방법들에 대해서는 무관심하였다.

오히려 최적화 방법들을 범죄인양 페널티를 주는 것으로 검색결과 검열에 많은 노력을 기울이고 있다. 부정적인 방법으로 혼란을 줄 수 있는 사이트들을 제거되어야 마땅하겠지만 여전히 많은 사이트들은 최소의 비용으로 검색결과 상위에 노출되기를 원하고 있다.

하지만 검색포탈들은 돈을 지급하는 사이트가 우선적으로 보호되고 실제로 양질의 콘텐트를 보유하고 있는 사이트가 순위에서 배제되는 조작된 검색결과를 보여주고 있는 셈이다.

마이크로 사이트와 블로그를 통해 활성화된 인위적인 링크가 검색포탈의 공정한 검색결과를 제공하는데 문제가 되는가?

각각의 사이트들은 정상적인 최적화 기법을 통해서 잘 만들어진 사이트이고 검색엔진의 콘텐트 질에 대한 평가에서 높은 우선 순위를 받기 위해서 다양한 방법으로 양질의 콘텐트를 구성한다. 그리고 상호 링크를 통해서 인위적인 링크 우선 순위를 높이는 방법을 활용한다.

개인적인 생각으로는 이런 사이트가 늘어난다는 것은 어찌되었든 인터넷 콘텐트가 양과 질적으로 발전하고 있다고 본다. 최적화 기법 중 가장 큰 요소가 주기적인 콘텐트 업데이트와 타이틀 교체, 다양한 외부링크 접속 등 사이트를 잘 운영하고 관리하는 것이 핵심이다.

한번 만들고 버려진 많은 대기업 사이트들이 최적화 기법을 이해한다면 운영에 좀 더 많은 신경 쓸 것이다. 얼마든지 긍정적인 요소가 많이 있다.

오히려 필자는 검색포탈들이 싫어하는 검색엔진 최적화가 인터넷 콘텐트의 발전에 더 많은 기여를 하고 있다고 생각한다. 어차피 검색포탈들의 콘텐트 검열에서 유해사이트나 스팸사이트는 충분히 걸려진다.

그리고 남은 콘텐트에 대한 추가적인 검열이 왜 필요한지 의문이다. 오히려 검색결과 검열이 콘텐트의 발전과 사이트의 활성화에 저해가 되는 것이 아닌가 생각이 든다.

인터넷 생태계가 더 이상 검색포탈의 수익모델의 희생자가 되어서는 안될 것이다. SEM(검색엔진마케팅)이 검색포탈을 위한 조직이라면 SEO(검색엔진최적화)는 웹사이트 제작사를 위한 조직인 셈이다. 검색포탈들의 수익성 여부를 떠나서 상호 공존할 가치가 있는 서비스라고 생각된다

'렛츠웹 + 게임 > IT News' 카테고리의 다른 글

| 잘나가던 웹사이트들은 어디로 갔을까? (0) | 2009.01.06 |

|---|---|

| "흥얼거리기만 해도 노래 찾아드려요" (0) | 2009.01.06 |

| “세컨드라이프, 새로운 비즈니스 기회” (0) | 2009.01.06 |

| 구글 압도적 1위·네이버 5위…지구촌 '검색천하' (0) | 2009.01.06 |

| 검색 제국’ 네이버 파열음, 성장통인가 쇠락 조짐인가 (0) | 2009.01.06 |

글

구글 압도적 1위·네이버 5위…지구촌 '검색천하'

전 세계 검색엔진(포털) 순위 조사결과에서 NHN(네이버, http://naver.com)이 5위, 중국 바이두(baidu, http://baidu.com)가 3위를 기록했다. 주당 600달러를 넘으며 미친 듯이 질주하고 있는 구글은 전체 검색 쿼리의 60%를 차지하며 2위를 기록한 야후와 4위인 MSN(윈도 라이브)을 제치고 부동의 1위를 고수했다.

AP, AFP 통신은 시장조사기관 컴스코어(comScore, http://www.comscore.com)가 9일(현지시각) 발표한 자료를 인용, “구글이 세계 인터넷 검색 시장을 압도하고 있다”며 “아시아 시장에서 바이두와 NHN의 약진을 통해 검색은 이미 세계적인 현상(become a truly global phenomenon)이 되고 있다”고 진단했다.

이번에 컴스코어가 발표한 연구 결과는 지난 8월 한 달 동안 검색을 통해 광고 수익을 얻는 전 세계 검색엔진들의 쿼리를 대상으로 처음 조사한 것이다. 특히 아시아 시장에서는 8월 한 달 동안 발생한 전 세계 610억 회 누적 검색쿼리 중 203억 회를 기록하며 세계 검색 흐름을 이끌고 있는 것으로 나타났다. 610억 회라는 기록은 매 분당 ‘140만회’에 달하는 엄청난 규모다.

자료에 따르면 전 세계 인터넷 사용자의 95%인 7억5000만 명이 한 달 동안 약 610억 회를 검색했다. 이 중 구글이 371억 회(유튜브 50억 회)를 차지하며 전체 검색횟수의 60%에 달했다.

야후는 쿼리 85억 회를 기록하며 2위, 중화권 최대 검색엔진 바이두가 32억 회로 3위, MSN 및 윈도 라이브 검색이 22억 회를 기록했다. 특히 포털사이트 네이버를 운영하고 있는 NHN이 20억 회로 5위를 차지하면서 세계적인 검색 비즈니스 업체로 부상했다.

중국, 일본, 인도 등을 포함한 아시아 태평양 지역 2억5800만 명이 참여하는 검색 쿼리가 203억 회에 달하며 세계 검색 시장의 상당수를 차지했다. 유럽은 2억600만 명이 사용하며 160억 회를 기록했다. 그러나 중동 지역은 사용자 3000만 명으로 20억 회에 그치면서 가장 검색 서비스가 활성화되지 않는 곳으로 나타났다.

밥 이빈(Bob Ivins) 컴스코어 부사장은 자료에서 “아시아 검색엔진이 구글과 야후 다음 순위라는 것은, 검색인 전 세계적인 현상임을 나타내준다”며 “특히 구글을 제치고 중국에서 선전하고 있는 바이두는 현지 토종 업체가 어떻게 전 세계 5대 검색엔진으로 성장할 수 있는지 잘 보여 준다”고 평가했다.

◆NHN-구글, 잘나가는 기업들의 공통 법칙 ‘시가총액’

이러한 결과가 당연하다고 자랑이라도 하듯 구글과 네이버의 주가 상승세도 거침없다. 구글은 지난 8일(현지시간) 사상 처음으로 주당 600달러를 돌파하는 등 고공행진을 계속하고 있다. 이날 나스닥에서는 장중 610.26달러, 종가 609.62달러까지 상승하면서 지난 12거래일 동안 6차례나 사상 최고치를 경신했다.

이는 지난 2004년 8월에 결정된 공모가인 주당 85달러 이후 약 3년 만에 무려 7배 이상 오른 것이다. 지금까지 주가 600달러 이상을 기록한 종목은 워렌 버핏 ‘버크셔 해서웨이’와 ‘시보드’, ‘시카고상품거래소(CME)그룹’, ‘워싱턴포스트’ 등 6개에 불과하다.

NHN도 시가총액 12조를 돌파하며 인터넷산업 대표주인 KT 뒤를 바짝 따라붙었다. NHN은 지난 8일 한때 52주 신고가 기록인 25만1500원까지 올라 시가총액 12조원을 돌파했다. 유가증권시장의 KT와 수천억 원 차이로 좁혀진 것이다. 기관의 목표주가도 일제히 30만 원 이상으로 껑충 뛰어올랐다. 이렇게 되면 12조3000억 원인 NHN의 시가총액이 15조원에 육박하게 된다.

10일에는 외국인들의 차익실현 목적 매물이 쏟아지면서 최고점을 찍은 뒤 이틀 연속 하락하며 한때 23만 원대까지 떨어지기도 했지만, 향후 성장세를 의심하는 사람은 드물다. 시장에서는 이미 “KT(12조8000억원)를 따라잡는 것은 시간문제”라며 ‘SK텔레콤’ 추월 가능성까지 제기되고 있는 상황이다. 현재 거래소의 시가총액 10위 안에 드는 곳은 현대차(15조1000억원), SK텔레콤(17조5000억원) 등이다

'렛츠웹 + 게임 > IT News' 카테고리의 다른 글

| 검색엔진 최적화는 검색포탈의「악의 축」인가? (0) | 2009.01.06 |

|---|---|

| “세컨드라이프, 새로운 비즈니스 기회” (0) | 2009.01.06 |

| 검색 제국’ 네이버 파열음, 성장통인가 쇠락 조짐인가 (0) | 2009.01.06 |

| 마침내 모습을 드러낸 야후의 소셜 네트워크「매시」 (0) | 2009.01.06 |

| 국내서도 ‘위키피디아’ 바람 (0) | 2009.01.06 |

글

네이버 일본검색 엔진, 정보 모으기는 성공할까

NHN(네이버)가 최근 일본의 검색 시장 공략을 위한 새 검색 엔진의 전용 크롤러(검색로봇, User Agent)를 국내 웹사이트를 대상으로 본격 가동하기 시작했다.

이에 앞서 네이버는 지난 3월 말부터 일본내 검색엔진 사업을 준비하기 위해 일본어 웹페이지에 대한 검색 색인 정보가 수집 활동을 시작했었다. 국내 검색 엔진의 해외 시장 본격 진출을 알리는 네이버의 일본어 검색서비스는 내년에 시작될 예정이다.

일본어로 검색 서비스를 준비중인, 네이버의 일본 검색엔진이 왜 한국어 웹 페이지를 대상으로 색인 정보를 수집해 가는 지는 아직 미지수이다.

- ▲ 네이버봇의 문제점을 지적하고 있는 위키피디아 일본어판. 특정 검색엔진 로봇의 문제점이 온라인 백과사전에 소개된 것은 매우 이례적이다. / 서명덕 기자

조선일보가 5일 확인한 자료에 따르면 내년 초 일본 진출을 계획하고 있는 네이버는 현재 알파 단계의 검색엔진을 개발 완료하고 테스트를 진행하고 있다.

실제로 지난달부터는 '예티(Yeti/0.01 nhn/1noon, yetibot@naver.com, check robots.txt daily and follow it)'라는 이름의 웹사이트 검색로봇이 일부 국내 한글 홈페이지들을 매일 수십~수백차례씩 방문하고 있는 것으로 파악됐다. 또한 해당 크롤러의 IP 주소 역시 61.247.219.41 ~ 50 등으로 다양해 상당한 수의 검색 로봇이 국내 웹사이트를 동시에 훑고 있는 것으로 파악된다.

특히 '첫눈(1noon)'이라는 명칭을 로봇 제작자 nhn과 병기한 점, 그리고 '설인(雪人)'을 뜻하는 'Yeti'를 로봇 명으로 사용했다는 점에서 첫눈(http://www.1noon.com)의 스노우랭크 검색 기술이 기반이 됐음을 간접 시사하고 있다.

네이버는 그 동안 웹 검색 서비스를 위해 '네이버봇'(Mozilla/4.0 compatible; NaverBot/1.0; http://help.naver.com/delete_main.asp)이라는 이름의 크롤러를 간헐적으로 운영해 왔으나, 국내에선 활발하게 활동하지 않았다. 이는 네이버의 검색 서비스가 웹 검색에 촛점이 맞춰진 것이 아니라, 네이버 내부의 통합 검색에 집중되었기 때문이다.

◆日서는 지난 3월부터 새로운 검색엔진 '예티' 가동된 듯…'네이버봇'의 실패를 극복할까?

네이버의 새로운 검색 로봇 예티는 어도 지난 3월 말부터 활발한 활동을 하며 일본 주요 웹사이트를 수집한 것으로 보인다. 이에 대해 일부 일본 네티즌들은 "한국 네이버에서 온 검색 로봇"이라며 경계하고 있다.

조선일보 취재 결과 네이버 재팬은 일본 웹사이트를 검색하기 위해 지난 3월 말까지 운영한 크롤러 '네이버 봇(Naverbot)'이 웹사이트 안정성을 훼손할 정도로 빈번하게 웹사이트에 접속했다는 비판을 받았다. 특히 서버가 튼튼하지 않은 일본내 영세 웹 사이트 관리자들로부터 비판을 받았던 것으로 확인됐다.

실제로 세계적으로 유명한 백과사전 위키피디아 일본어판에서는 '네이버봇'(http://ja.wikipedia.org/wiki/NaverBot)에 대해 비판적인 설명을 하고 있다. 위키피이다 일본어판은 "과거 네이버봇은 크롤러로서 알고리즘이 나빠 문제가 됐다"며 "거의 초 단위로 리퀘스트를 실시하면서, DoS 공격과 유사한 정도에 달해 서버를 불안정하게 할 우려가 있다"고 비판하고 있다.

이 자료에서는 "네이버봇은 일본어 웹사이트를 수집할 때 인덱스에 사용될 것 같은 웹페이지들을 유무를 확인하지 않고 무차별 확인한다"며 "세션을 식별하지 않을 뿐만 아니라, 같은 URL에 대해서 세션만 바꾼 채 잇달아 리퀘스트를 실시하고 있고, (검색엔진이 지켜야 하는 공통 국제규약인) robots.txt도 무시한다"고 지적했다.

또 이 사전에서는 "NABOT/5., nhnbot, minibot(NaverRobot), dloader(NaverBot), nabot, Cowbot, NaverBot-1.0+ 등 다양한 방식으로 이름을 바꿔 웹사이트에 접근했다"며 "네이버봇을 거부하는 일본 웹사이트가 증가했다"고 소개했다.

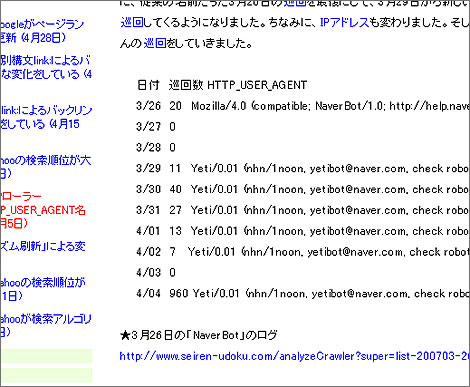

이와 관련 일본의 한 검색엔진 전문 블로그(http://www.seiren-udoku.com) 운영자는 지난 4월 초 올린 글에서 "네이버봇은 자주 크롤러(HTTP_USER_AGENT) 명칭을 바꾸는 것으로 유명하다"며 "지난 3월 26일을 마지막으로 네이버봇 접근이 사라졌으며, 3월 29일부터는 '예티'라는 새 이름으로 접근하고, IP 주소도 바뀌었다"고 확인하고 있다.

이 뿐만 아니라 일본 주요 포털사이트나 블로거들 역시 "네이버봇을 주의해야 한다"고 말하고 있다. 야후 재팬은 물론이고 구글 재팬에서도 '네이버봇 거부 금지(일본어로 NaverBot 拒否/禁止)' 등의 단어로 검색하면 수십~수백건의 글이 쏟아진다.

이러한 분위기가 수그러들지 않으면서 네이버가 새로 내 놓은 검색로봇 '예티'까지 네이버봇의 악명을 물려 받고 있는 형국이다. 로봇이 본격 가동되면서 일본 웹사이트 관리자들은 "또 네이버가 이름을 바꿨는가"라는 의견을 잇달아 내 놓고 있다. 예티의 크롤러 서버 IP를 직접 파악해 원천적으로 막는 일본 네티즌들도 다수 있을 정도다. 검색엔진 접근이 잇달아 차단되면 색인이 불가능하기 때문에 당연히 검색 품질이 떨어질 수 밖에 없다.

일본 네티즌들은 야후, 구글, 바이두의 검색로봇 접근 횟수와 네이버 예티 로봇의 접근 횟수를 비교한 자료를 제시한 뒤, 예티가 너무 빈번하게 웹 사이트의 색인 정보를 긁어가고 있다고 비판하고 있다.

이에 대해 네이버 관계자는 "과거 일본어 검색에 이용됐던 네이버봇과 달리, 새로운 로봇은 통상적인 수준의 작업을 하고 있다"며 "야후나 구글도 크롤링 빈도가 만만치 않다"고 말했다. 네이버측은 일본 웹 사이트의 관리자로부터 원성을 듣지 않으면서, 동시에 일정 검색 서비스 품질을 유지하기 위한 합리적인 수준의 웹 크롤링을 하기 위해 고민중인 상태이다.

- ▲ 지난 4월 네이버 재팬의 '예티' 검색로봇의 등장을 알리고 있는 일본 블로거 / 서명덕 기자

◆중국 최대 검색엔진 '바이두'도 유사 논란에 공식사과

사실 일본에 진출 검색엔진이 검색로봇 때문에 일본 네티즌들의 반발을 산 것은 비단 네이버 뿐만이 아니다.

중화권 최대 검색엔진 바이두(百度, http://baidu.com)가 지난해 말 ‘일본 진출’을 선언했지만, 올해 초 일부 일본 개발자들을 중심으로 ‘反바이두’ 움직임이 일었다.

사태의 발단은 바이두가 지난해 말 첫 해외 진출로 “일본에서 일본어 서비스를 시작하겠다”고 밝히면서다. 바이두는 12월부터 본격적으로 일본어 검색로봇 ‘바이두 스파이더(Baiduspider)’를 가동하며 일본 웹사이트 정보를 무차별 수집(인덱싱)하기 시작했다.

문제는 바이두 검색로봇이 많게는 1초에 수차례 웹서버에 접근하는 등 지나치게 웹사이트를 훑는 경우가 많아 사이트 안정성을 위협할 지경에 이르렀던 것이다. 구글이나 야후 재팬 등 주요 검색사이트에서 ‘Baiduspider’ 등의 키워드로 검색하면 “바이두 검색로봇 접근을 막겠다” “바이두 검색로봇은 웹서비스 기본 예의가 없다”는 등 비난하는 의견이 쏟아졌다.

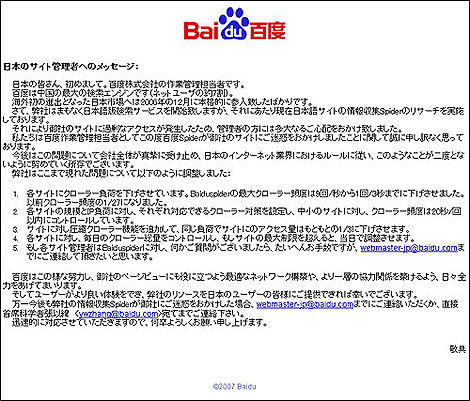

당시 사태가 악화되자 바이두 일본어 서비스 담당자는 지난 2월 17일 아직 개설하지도 않은 바이두 일본어 홈페이지(http://www.baidu.jp)에 ‘진심으로 사과한다’는 임시 공지사항을 내걸고 사태 진화에 나섰지만 부정적인 시선을 무마하기에는 역부족이었다.

‘일본 웹사이트 관리자에게 보내는 메시지’라는 이 공지에서 바이두는 “해외 첫 진출인 일본 시장에는 지난해 12월부터 본격적으로 진출했다”며 “일본어 검색서비스를 하기 위해 일본어 사이트 정보를 수집하는 검색로봇 리서치를 실시하고 있다”고 말했다. 이러한 과정에서 일부 웹사이트에 과도한 접근(액세스)이 발생, 관리자들에게 막대한 영향을 끼쳤다는 설명이다.

바이두 측은 “바이두 담당자로서 바이두 검색로봇이 사이트에 피해를 끼친 점을 정말 미안하게 생각한다”며 “향후 이 문제에 대해 회사 전반에서 진지하게 받아들이고, 일본 인터넷업계의 규칙에 따라 두번 다시 이런 일이 없도록 노력하겠다”고 덧붙였다.

현재 일본 검색 시장은 소프트뱅크와 손잡은 야후재팬이 부동의 1위를 달리고 있으며, 구글 재팬이 2위로 그 뒤를 추격하고 있다.

- ▲ 바이두 재팬이 지난 2월 웹사이트에 게재한 공식 사과문. / 서명덕 기자

◆검색로봇(크롤러) = 검색엔진이 검색 데이터베이스의 내용을 색인 및 보충하기 위해, 대상 웹페이지를 자동으로 검색하여 가져오는 컴퓨터 소프트웨어다. 검색 서비스를 제공하기 위해서는 반드시 검색로봇이 돌아다니면서,정보를 수집해와야 한다. 보통 스파이더(spider), 봇(bot), 지능 에이전트 등으로도 불린다. 검색로봇은 새로운 웹페이지를 찾아 종합하고, 찾은 결과를 이용해 또 새로운 정보를 찾아 색인을 추가하는 작업을 사람의 개입 없이 반복 수행한다.

검색로봇에 의해 검색되지 않기를 원하는 웹 자료는 저장할 때 HTML파일 내에 검색을 거부하는 것을 명시한 메타태그(Meta Tag)를 써 넣거나 웹 서버의 공개 디렉토리 최상위 영역에 로봇 검색 영역을 규정하는 robots.txt를 넣으면 된다.

'렛츠웹 + 게임 > IT News' 카테고리의 다른 글

| '미운오리' P2P, 회선비 절감 대안으로 급부상 (0) | 2009.01.06 |

|---|---|

| 쇼핑몰, 해외 구매대행 서비스 `속속 (0) | 2009.01.06 |

| 다음, 오픈 플랫폼에 기반한 지도 API 공개 (0) | 2009.01.05 |

| 5가지 기술 트렌드가 5년후 사회 바꾼다 (0) | 2009.01.05 |

| "블로그는 기성 뉴스에 없던 '대화'를 복원한 것" (0) | 2009.01.05 |